🧩 成果報告で一番疲れるのは「技術の説明」かもしれない

エンジニアとして製品開発をしていて、こんな場面に心当たりはありませんか?

- 時間をかけて作り込んだモデル、データ、仕組み…

- 開発段階では誰からも文句を言われず、順調に進む

- いざ「報告」のタイミングになると──「で?結局何がいいの?」

……あれだけ頑張ったのに、一言で片付けられる理不尽。

私がまさにそうでした。

顧客現場に導入したセンサーデータ付き製品に、Pythonで構築した異常検知モデルを適用。

再現性もあり、精度も申し分なし。技術的な達成感も高かった。

でも、報告の場では──

「で? この技術って、結局どう役に立つの?」

思わず「いや、意味あるからやったんですけど…」と心の中で叫びましたが、それをうまく言語化できなかった自分にもモヤモヤ。

上司や他部署の人たちは、プログラミングやAIには詳しくない。

細かく話せば話すほど伝わらないし、抽象的に話せば「ふーん」で終わる。

結果、「成果」として評価されるどころか、説明不足と見なされてしまう。

──正直、開発より説明のほうがしんどい。

この経験が、私に「技術を翻訳する力」の必要性を突きつけてくれました。

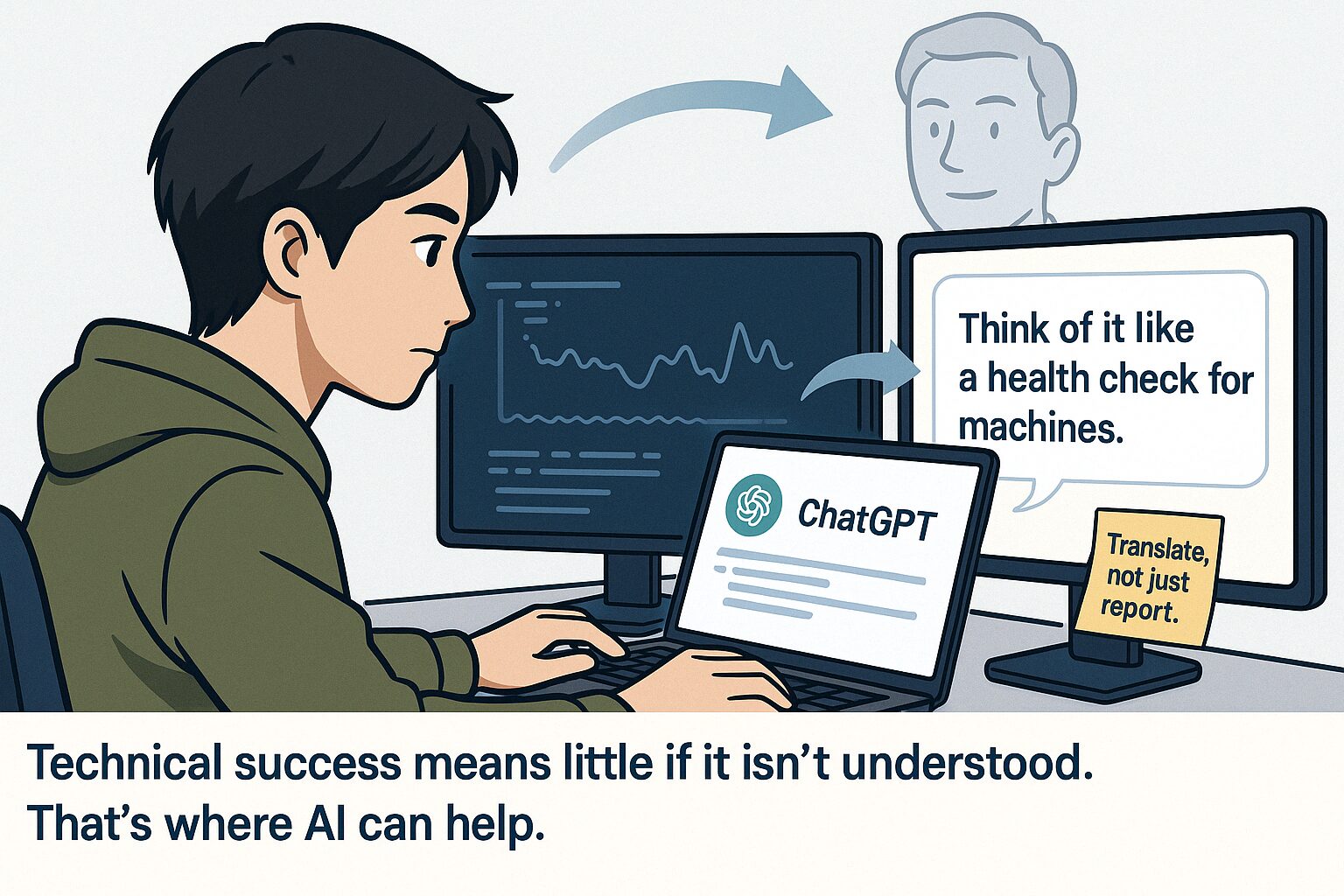

ChatGPTを“技術の伝え方相談役”にしてみたら、頭の中が整った

「意味はあるはず…でも、どう伝えれば?」と、悩み続けていました。

私は普段、ChatGPTをコードの添削や資料の下書き程度にしか使っていませんでした。

でもあるとき、ふとこんな問いかけをしてみたんです。。

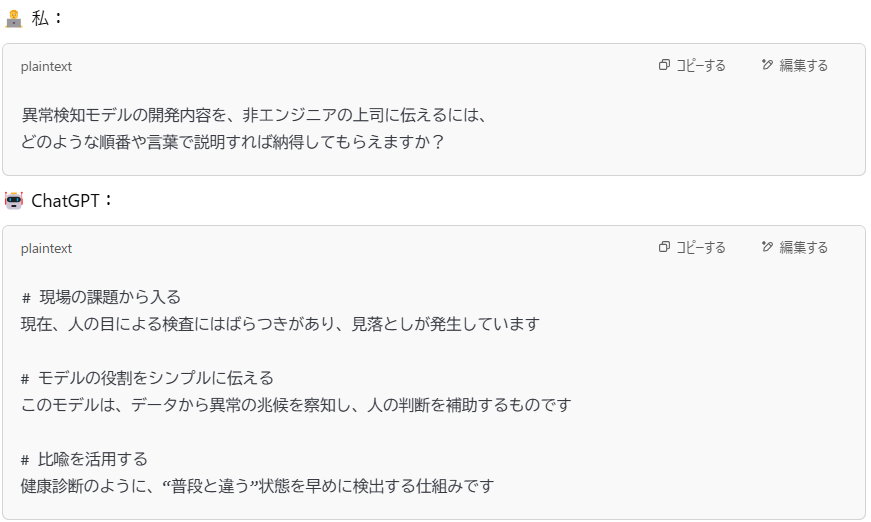

たとえば、こんなプロンプトを投げたんです。

すると返ってきたのは、──

- まずは「検査のばらつき」という現場の課題から入る

- モデルは“判断の補助”であることを明確に伝える

- 仕組みの例えとして“健康診断”を使う

……などなど、**「あ、それでいいのか!」**と思わせてくれる視点も出てきます。

とはいえ──

**「ここまではまあ、当たり前。でも、この先が難しいんだよな…」**という感覚が正直ありました。

なので、さらに踏み込んで問いかけてみたんです:

📌 現場で「説明の順番」を間違えると、伝わらない

実はそれまでの私は、

“AIの仕組み”→“モデルの精度”→“再現性”→“使った手法”

……という、“技術者の理屈の順番”で話していたんです。

でも現場の人が知りたいのはそこじゃない。

- 何が問題だったのか

- どんな改善ができたのか

- それは誰の負担を減らすのか

──つまり、**「技術の中身」よりも「効果と意味」**が大事なんです。

ChatGPTに壁打ちする中で、私はようやくそれに気づけました。

まさにこのやり取りで、**「技術は説明するものじゃなく、“翻訳”するものなんだ」**と痛感しました。

ChatGPTは“反応が薄い上司”を完コピしてくれるAIだった

ChatGPTと何度か壁打ちをしていくうちに、ある変化に気づきました。

一番変わったのは、自分の“説明の順番”と“思考の整理”のしかただったんです。

たとえば──

- 「これは当然伝わるでしょ」と思っていた言葉が、意外と通じない

- データの話から入ると、そもそも聞く気を失われる

- 要点を後回しにすると、「で、結局なに?」と返ってくる

この“かみ合わなさ”、まるで現場でよくある、反応の薄い上司との会話そのものでした(笑)

でも、むしろありがたかったのは、ChatGPTが**「話したい順番」じゃなく「伝わる順番」を優先する視点**をくれたこと。

話す前に、一度ChatGPTに伝えてみる。

そこでうまく伝わらない箇所=“上司も理解しにくいであろう部分”と考えるようになりました。

💡実際に私は、以下のような整理を意識するようになりました:

- 聞き手が知りたい順に並べる(成果 → 課題 → 手法 の順で話す)

- 比喩や例えを冒頭に置く(データ分析=健康診断 など)

- 数字や専門用語の導入タイミングを後ろにずらす(いきなり精度の話をしない)

ChatGPTは無表情でツッコミを入れてくるけど、それがちょうどよかったんです。

「うまく伝わってるか?」を試す相手として、非エンジニア視点のシミュレーターみたいな役割を果たしてくれました。

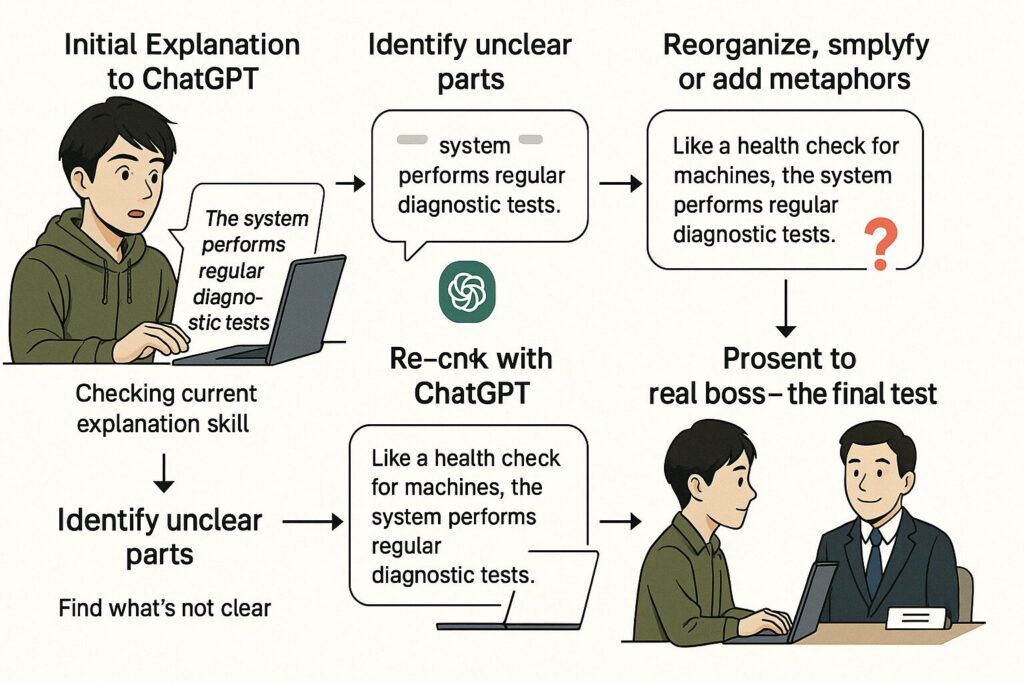

ChatGPTで“伝わる説明”を組み立てる、私の壁打ちルーティン

ChatGPTとのやりとりを続けていると、だんだんと**“伝える準備の型”**ができてきました。

今でも私がやっているのは、こんな流れです:

- ChatGPTにざっくり開発内容を説明する

└ 専門用語はあえてそのまま使って、まずは“現状の説明力”をチェック。 - 「これだと伝わらないかも」と言われた部分を整理する

└ ChatGPTが反応薄い=リアル上司もたぶん反応しないポイント。 - 導入を変える、比喩を入れる、順番を入れ替える

└ 例:「再学習による精度向上」→「健康診断で異常を早期発見できる仕組み」と言い換える。 - 「この伝え方、どう思う?」とChatGPTに再確認する

└ 想定されるリアクションや補足のヒントまでくれるので、抜けが減る。 - リアル上司で実戦テスト(ここが本番)

└ 反応が良かったらそのまま資料化。微妙ならChatGPTに戻って調整。

このルーティンを回すだけで、資料を作る前に「何を伝えるか」が明確になっている状態になるんです。

しかも、AI相手だから何度やっても怒られないし(笑)、

“人前でつまずく前に、つまずける”のが最大の利点だと思っています。

まとめ:成果は「やったもん勝ち」じゃなく、“伝えたもん勝ち”

どれだけすごい仕組みを作っても、

どれだけ複雑な処理を突破しても、

それが伝わらなければ、評価も進展もない。

──これが、現場で何度も感じたリアルです。

実際、私が作った異常検知モデルも、

精度は出ていたし、動作も安定していた。

でも、それが**“なぜ価値があるのか”**をうまく言語化できなかったことで、

報告のたびに「で、それって何のため?」と立ち止まられました。

でもChatGPTと壁打ちするようになってからは、

その状況が大きく変わってきました。

- 技術の話を「相手が聞きたい形」に変換できるようになった

- 報告資料を作る前に、伝える順番が整理されている

- 「上司からのツッコミ」に事前に気づける余裕ができた

これは単なる“AIの使い方”ではなく、

「伝える力」の筋トレを毎回サポートしてくれる存在ができたということ。

成果は、やった時点ではまだ未完成。

“相手に届いたとき”に、ようやく価値になる。

ChatGPTはその「伝わるまでの距離」を縮めてくれる、

もうひとりのロジカル上司、もしくは伝達力の補助エンジンみたいな存在です。

コメント